Wij geloven dat technologie pas echt waardevol is als die iets toevoegt aan mens en maatschappij. Daarom kijken we altijd naar hoe we bestaande systemen slimmer kunnen maken, zonder meer data te verzamelen dan nodig. Ons project voor 99gram.nl is daar een mooi voorbeeld van.

Van forumdata naar waardevolle inzichten

Het forum van 99gram bestaat al bijna 15 jaar. Onder de oppervlakte bevat het een schat aan gegevens: duizenden berichten en reacties die zorgvuldig zijn beheerd door moderators. Wat bijzonder is aan deze data, is dat ze al voorzien zijn van menselijke labels. Een moderator heeft immers telkens beoordeeld of een bericht veilig, ongepast of spam was.

Dat maakt deze dataset ideaal om te gebruiken in een machine learning-model. Niet om meer data te verzamelen, maar om de bestaande betrouwbare data beter te benutten.

Een eigen model, in plaats van data delen

Natuurlijk zouden we zo’n taak kunnen uitbesteden aan een Large Language Model (LLM) zoals OpenAI. Maar dat levert twee problemen op:

- Privacy: je deelt mogelijk privacygevoelige data met een externe partij (buiten de EU).

- Hoge kosten: er zijn terugkerende kosten aan verbonden.

Daarom hebben we gekozen voor een andere aanpak: ons eigen classificatiemodel trainen, specifiek voor 99gram. Zo blijft alle data lokaal, binnen een veilige en gecontroleerde omgeving, wat volledig in lijn is met onze ISO 27001-normen voor informatiebeveiliging.

Eisen aan verantwoord trainen

Voordat we begonnen, stelden we duidelijke eisen aan de dataset en het proces:

- De data moest schoon zijn: verwijderde of gevoelige berichten werden gefilterd.

- Er mocht geen persoonlijke informatie in de trainingsdata terechtkomen.

- De kwaliteit moest hoog zijn: de moderatie-historie van 99gram maakte dat mogelijk.

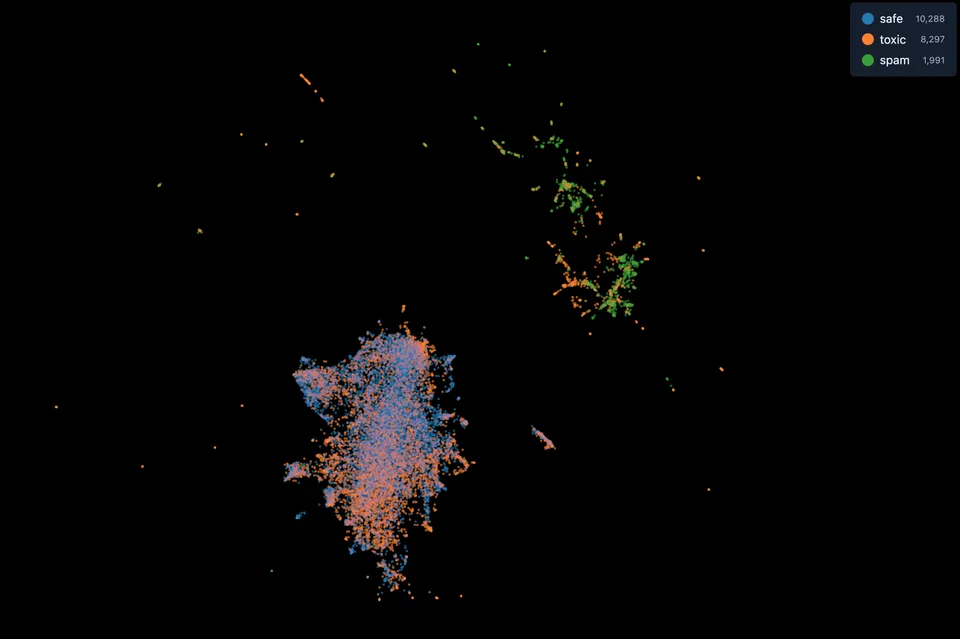

Zo ontstond een natuurlijke trainingsset met betrouwbare labels:

- Safe: berichten die online en publiek zichtbaar zijn.

- Toxic: berichten die door moderators zijn verwijderd.

- Spam: berichten die door automatische filters zijn tegengehouden.

Van ruwe data naar een getraind model

Met deze dataset hebben we het model stap voor stap opgebouwd. Eerst verzamelden we alle relevante onderwerpen en reacties uit de database. Daarna schonen we de data op en verdeelden we die in twee sets:

- een trainingsset om het model te leren herkennen wat veilig of schadelijk is,

- en een evaluatieset om de prestaties te testen en bij te sturen.

Voor het trainen gebruikten we een embedding-model, dezelfde technologie die we eerder succesvol toepasten bij AcademicTransfer. Dankzij de snelle vooruitgang in dit domein kunnen we nu zonder enorme infrastructuur krachtige AI-modellen draaien, gewoon binnen onze eigen omgeving.

Inspiratie

Aan de hand van dit prototype kregen we meteen nieuwe ideeën:

- Realtime moderatie: nieuwe berichten en reacties worden automatisch gecontroleerd voordat ze zichtbaar worden. Zo kunnen we het forum veilig houden zonder de menselijke controle te verliezen.

- Ondersteuning van hulpverleners: het model kan berichten classificeren en signalen van zorg of risico markeren, zodat hulpverleners sneller kunnen handelen.

- Trainen van hulpverleners: het model kan realistische chatgesprekken voeren op basis van de berichten op het forum.

Wat dit laat zien

Dit project laat zien hoe AI en Machine Learning op een verantwoorde manier kan worden ingezet voor bedrijfskritische applicaties en maatschappelijke platforms. Door slim gebruik te maken van bestaande data, bouwen we aan systemen die veiliger, duurzamer en betaalbaar zijn, zonder afhankelijk te worden van externe AI-diensten.

Bij Leukeleu geloven we dat dit de toekomst is van softwareontwikkeling: technologie die niet méér data vraagt, maar meer doet met betrouwbare data.

Meer weten of heb je vragen?